시작하기 전에

이번에 Google Maching Learning Bootcamp에 붙었다. 퀄리티 있는 강의와 과제가 주어지니, 개념을 제대로 정리하고 과제를 통해 이를 활용하는 방법까지 정리하고자 한다. 추가로 내 지식, 리서치도 포함되었다.

I. Introduction to Deep Learning

딥러닝이 뭘까?

딥러닝의 개념을 알기 위해서 비슷한 개념인 데이터 분석, 머신러닝과 비교해보겠다. 모두 데이터를 분석하고 활용하는 툴이며 다 익숙한 단어지만 각각의 특징은 헷갈리는 경우가 많다.

데이터 분석

- 데이터를 검토하여 결론을 도출하고 의사 결정을 지원하는 과정이다.

- 통계적 방법, 시각화 도구, 그리고 분석 모델이 사용된다.

- 다른 둘보다 기술적 복잡성은 낮지만, 비즈니스 의사 결정에 직접적인 기여를 한다.

머신러닝

- 데이터로부터 학습할 수 있는 알고리즘을 사용하여 모델을 만드는 분야다.

- 지도학습, 비지도학습, 강화학습 등 여러 유형이 있다.

- 주로 예측 모델링과 패턴 인식에 사용되며, 비교적 복잡한 데이터셋에서 의미있는 결과를 도출할 수 있다.

딥러닝

- 머신러닝의 한 분야로, 인공 신경망을 사용하여 매우 복잡한 데이터의 패턴을 학습한다.

- 일반적으로 큰 데이터셋과 고성능 컴퓨팅 리소스를 필요로 한다.

- 이미지 인식, 음성 인식, 자연어 처리 등과 같은 고도의 문제를 해결하는 데 특히 효과적이다.

참고로 뒤에서 인공 신경망, Neural Networks 얘기가 많이 나온다.

II. Neural Networks Basics

Binary Classification

입력 이미지를 받아 Neural Network를 지나서 결과값을 1(고양이다) 또는 0(고양이가 아니다)으로 나타내는 것이다.

이미지를 입력받는 과정

컴퓨터가 인식할 수 있는 형태는 0110101... 같은 이진법이다. 이미지를 이러한 형태로 변화시켜줘야 한다.

컬러 이미지라면 Red, Green, Blue 3가지 색깔의 조합으로 이루어져 있기 때문에 쪼갤 수 있고, 특정 픽셀이 갖는 Red, Green, Blue 색상값을 각각 0~255의 숫자로 나타낼 수 있다. 그리고 이를 모두 (

그렇게 하면 training examples로 m개의 이미지가 들어왔을 때 X를 (

Logistic Regression

한글로는 로지스틱 회귀, 수학을 사용하여 두 데이터 간의 관계를 찾는 데이터 분석 기법이다. 그 중 하나를 살펴보겠다.

Sigmoid 함수

Binary Classification에서는 Neural Network를 지났을 때 결과값이 0~1로 표현돼야 이미지가 고양이가 맞는지 판단할 수 있다. 하지만 현재 상황으로는 결과값이 0~1에 위치할 것이라는 보장이 없다. 여기서 나오는 개념이 Sigmoid이다.

Sigmoid 함수를 통해 결과값을 0~1로 만들어줄 수 있다. 식은 아래와 같다.

결론은 아래와 같다.

※ 갑자기 모르는 개념이 많아요

※ 갑자기 모르는 개념이 많아요

하나하나 살펴보자.

- Transpose를 왜 적용하냐고 하면, 행렬의 곱셈에서는 아래 그림의 예시에서

- Transpose가 의미가 있는지 한 번 생각해보자. 위에서 살펴봤듯이

Cost Function

이는 각 데이터에서 나오는 Loss Function 값들의 총합이다. 따라서 우선, Loss Function이 무엇인지부터 보자.

Loss를 줄여가는 과정이 AI의 학습이다. Binary Classification에서 Loss Function은 아래와 같다. 다시 한 번 얘기하자면,

만약

반대로 만약

마지막으로 Cost Function은 이러한 Loss의 총합이므로 아래와 같다.

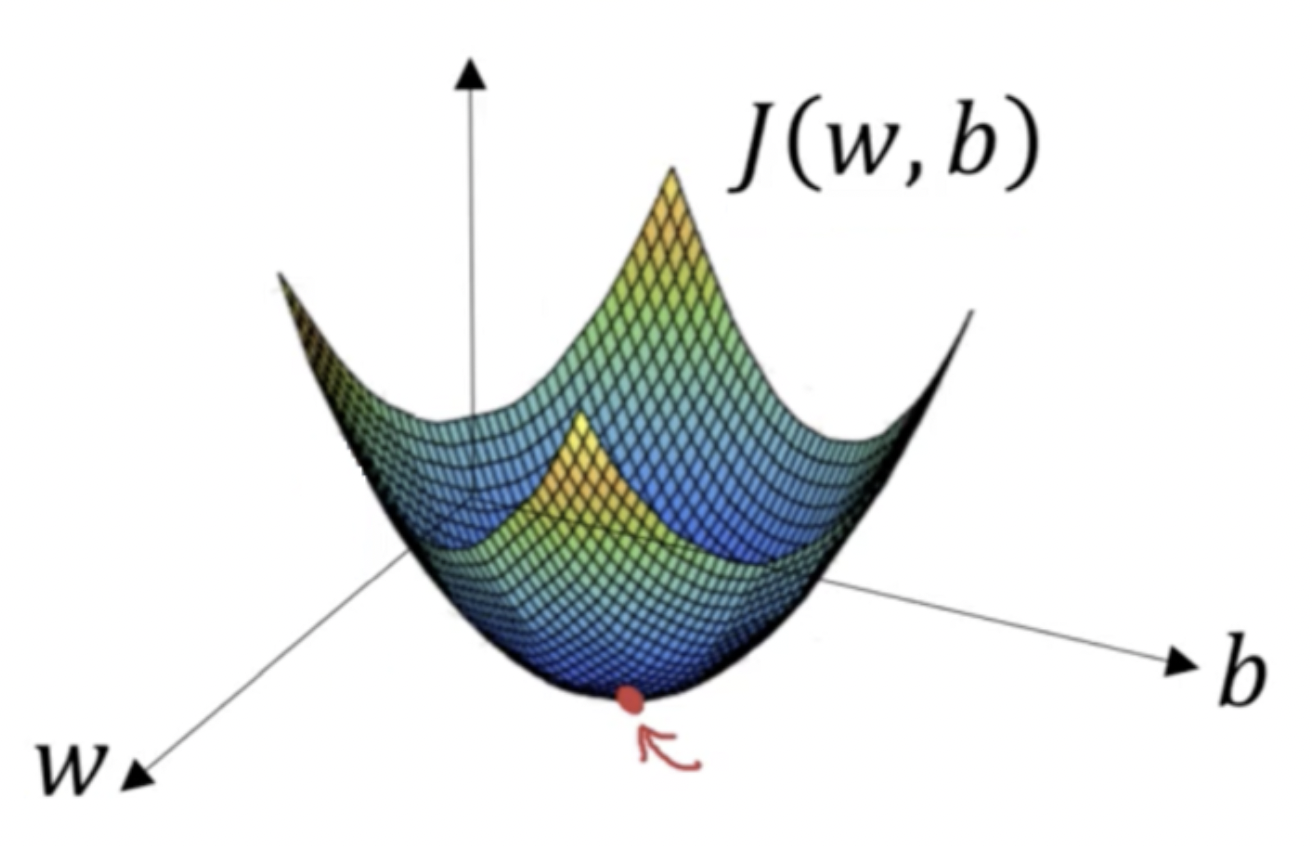

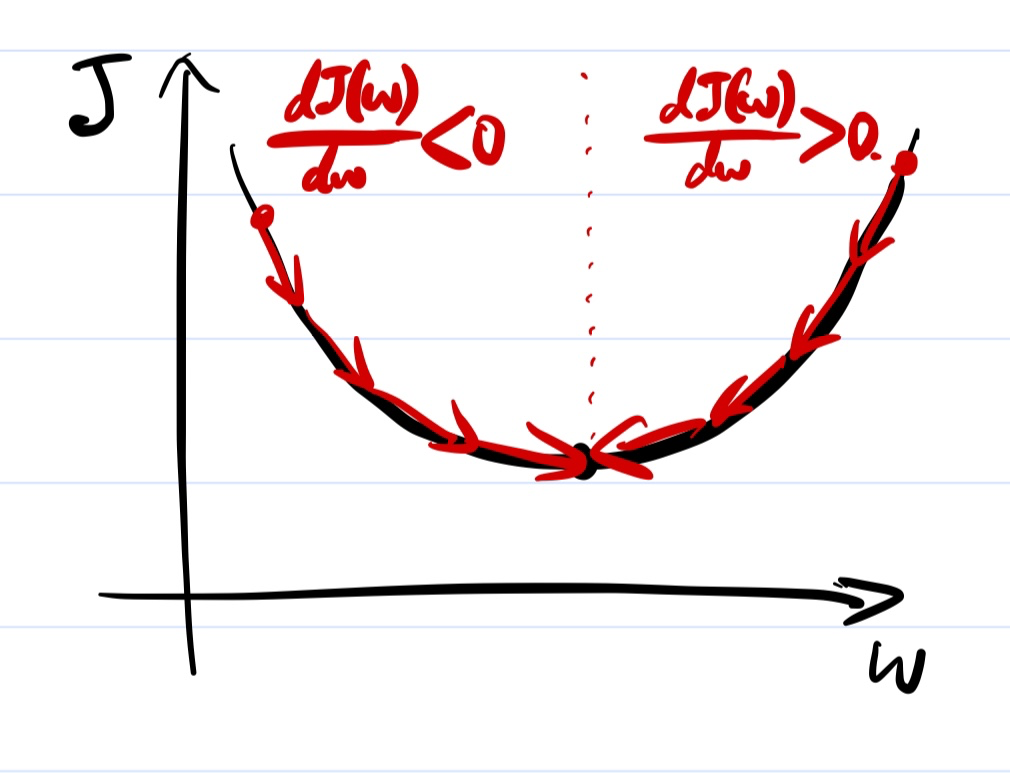

Gradient Descent

그렇다면

간단하게

식으로 표현하면 아래와 같다. 그리고

여기서

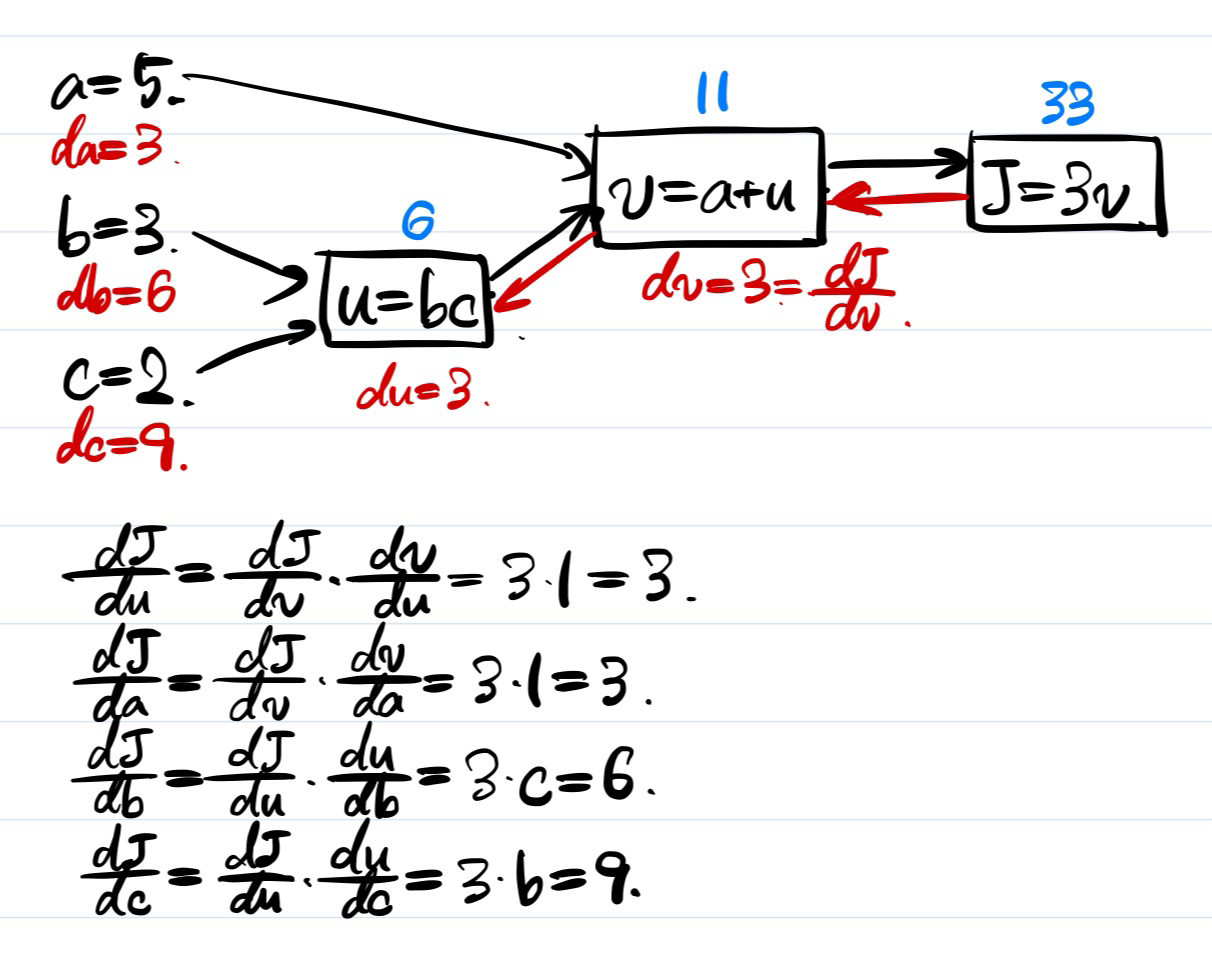

Computating Derivatives

위 그림에서 a, b, c의 값에 기반하여 파란색 부분을 모두 구해낼 수 있다. 그 후에 J부터 거꾸로 돌아오면서 각각의 derivatives를 계산할 수 있다. Chain rule을 활용해서 계산하는 방법을 살펴보자.

Vectorization

Vectorization은 굉장히 중요한 테크닉이다. 예를 들어,

마치며

다음 글에서는 III, IV를 정리하며 코스 1을 마무리하겠다.

'AI' 카테고리의 다른 글

| [머신러닝] Neural Networks and Deep Learning (2) (0) | 2024.07.18 |

|---|